NLP 中的迁移学习:利用预训练模型进行文本分类

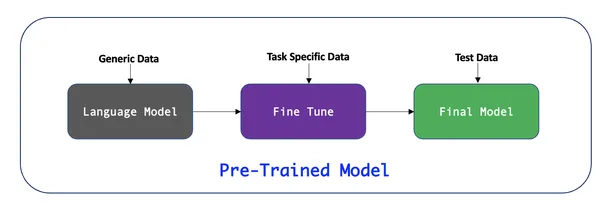

迁移学习允许从业者利用预先训练的模型来完成他们自己的任务,从而彻底改变了自然语言处理(NLP)领域,从而显着减少训练时间和计算资源。在本文中,我们将讨论迁移学习的概念,探索一些流行的预训练模型,并通过真实示例演示如何使用这些模型进行文本分类。我们将使用 Hugging Face Transformers 库来实现。

NLP 中迁移学习的出现

在 NLP 的早期,朴素贝叶斯、逻辑回归和支持向量机等传统机器学习模型流行用于解决与文本相关的任务。然而,这些模型通常需要大量标记数据和精心设计的特征才能获得良好的性能。

随着深度学习的出现,LSTM 和 CNN 等模型开始在 NLP 任务中流行起来,因为它们能够自动从原始文本中学习特征。然而,这些模型仍然需要大量标记数据才能获得良好的性能,并且在对长序列进行训练时会遇到梯度消失的问题。

Vaswani 等人介绍了 Transformer 架构。(2017) 标志着 NLP 研究的一个转折点。变形金刚引入了一种新颖的自我注意机制,使模型能够更有效地处理长序列并学习单词的上下文表示。这导致了预训练语言模型的发展,这些模型使用无监督学习目标(如掩码语言建模和下一句预测)在大量文本语料库上进行训练。

迁移学习成为一种流行的技术,可以利用这些预训练模型以相对较少的额外训练来解决特定的 NLP 任务。通过在更小的、特定于任务的数据集上微调预训练模型,从业者可以在减少训练时间和计算资源的同时获得最先进的结果。

流行的预训练模型

一些流行的 NLP 任务预训练模型包括:

BERT(Bidirectional Encoder Representations from Transformers): BERT 由 Google 开发,是一种基于 Transformer 的模型,已使用掩码语言建模和下一句预测任务对大型文本语料库进行了预训练。

GPT(生成式预训练转换器): 由 OpenAI 开发,GPT 是另一种基于转换器的模型,专注于语言建模的生成方面。

RoBERTa(稳健优化的 BERT 方法): 由 Facebook AI 开发的 BERT 变体,RoBERTa 通过使用动态掩码和对更多数据进行训练来改进 BERT。

还有其他值得注意的预训练模型,例如 XLNet、ALBERT 和 T5,它们具有自己独特的特性,适用于不同的 NLP 任务。

迁移学习在 NLP 中的优势

与传统的 NLP 技术相比,迁移学习具有几个优势:

改进的性能: 预训练模型已被证明可以在广泛的 NLP 任务上取得最先进的结果,通常优于传统的机器学习和深度学习模型。

减少训练时间:与从头开始训练模型相比,在更小的、任务特定的数据集上微调预训练模型可以显着减少训练时间。

更低的计算资源:通过利用从预训练模型中学到的知识,迁移学习减少了对大量标记数据和计算资源的需求。

广泛的适用性:迁移学习可以应用于各种NLP任务,例如文本分类、情感分析、命名实体识别、问答等,是从业者的万能技术。

使用拥抱面变换器进行文本分类

Hugging Face Transformers是一个开源库,可以轻松访问预训练模型并简化它们针对特定任务的微调。在此示例中,我们将使用 BERT 进行文本分类。

首先,安装必要的库:

pip install transformers pip install torch

接下来,让我们导入所需的库并下载预训练的 BERT 模型和分词器:

from transformers import BertTokenizer, BertForSequenceClassification

import torch

tokenizer = 域名_pretrained('bert-base-uncased')

model = 域名_pretrained('bert-base-uncased')现在,让我们为训练准备数据集。对于此示例,我们将使用 IMDB 电影评论数据集进行情感分析。数据集可以从这里下载。我们将使用 BERT 分词器对输入文本进行分词。

from transformers import TextDataset

def tokenize(batch):

return tokenizer(batch['text'], padding=True, truncation=True)

train_dataset = TextDataset("path/to/train_data", tokenize)

val_dataset = TextDataset("path/to/val_data", tokenize)接下来,我们将设置训练参数并训练模型。

\0

from transformers import Trainer, TrainingArguments training_args = TrainingArguments( output_dir='./results', num_train_epochs=3, per_device_train_batch_size=16, per_device_eval_batch_size=16, warmup_steps=500, weight_decay=域名, logging_dir='./logs', ) trainer = Trainer( model=model, args=training_args, train_dataset=train_dataset, eval_dataset=val_dataset, ) 域名n() #import csv

训练后,我们可以在验证数据集上评估模型并保存微调后的模型以备将来使用

\0

域名uate()

域名_model("fine-tuned-bert")使用微调模型进行文本分类

现在我们有了一个用于情感分析的微调 BERT 模型,我们可以用它来对新的文本样本进行分类:

def classify_sentiment(text):

inputs = tokenizer(text, return_tensors="pt")

outputs = model(**inputs)

logits = 域名ts

probabilities = 域名max(logits, dim=1).tolist()[0]

sentiment = "positive" if probabilities[1] > probabilities[0] else "negative"

return sentiment, probabilities

text = "I loved the movie! The acting was superb and the plot was engaging."

sentiment, probabilities = classify_sentiment(text)

print(f"Sentiment: {sentiment}, Probabilities: {probabilities}")此函数对输入文本进行标记,将其输入微调的 BERT 模型,并返回预测的情绪以及每个类别的概率。

迁移学习在 NLP 中的实际应用

迁移学习在各个行业和领域都有广泛的应用,例如:

客户支持:自动对客户投诉或查询进行分类,将其转至相应部门。

社交媒体监控: 分析社交媒体帖子以检测趋势、情绪或品牌提及。

医疗保健: 对医疗记录和临床记录进行分类,以识别潜在的诊断、风险或治疗方案。

财务: 分析新闻文章、财务报告或收益电话以预测股市趋势并做出明智的投资决策。

法律:自动对法律文件进行分类,以改进组织和信息检索。

通过利用迁移学习,组织可以开发复杂的 NLP 系统,提供有价值的见解并简化这些行业的各种任务。

结论和要点

在本文中,我们探讨了 NLP 中迁移学习的概念,讨论了 BERT、GPT 和 RoBERTa 等流行的预训练模型,并演示了如何使用 Hugging Face Transformers 利用这些模型进行文本分类。通过微调任务特定数据集上的预训练模型,我们可以显着减少训练时间和计算资源,同时获得最先进的结果。

本文的要点包括:

迁移学习是 NLP 中的一项强大技术,它允许从业者利用已经从大型数据集中学习到有用特征的预训练模型,以相对较少的额外训练来解决特定任务。

BERT、GPT 和 RoBERTa 等流行的预训练模型为 NLP 中迁移学习的成功做出了巨大贡献,在各种任务中取得了最先进的结果。

Hugging Face Transformers 是一个开源库,它简化了预训练模型的使用,并针对特定任务(例如文本分类)对其进行了微调。

在特定任务数据集上微调预训练模型可以显着减少训练时间和计算资源,同时保持高性能。

迁移学习已成为 NLP 从业者的一项基本技术,使他们能够更轻松、更高效地处理各种任务。

迁移学习的多功能性使其能够应用于广泛的 NLP 任务,使其成为从业者掌握的宝贵技能。

随着迁移学习的不断发展,我们可以期待更多先进的预训练模型和技术的出现,进一步增强 NLP 系统的能力。通过紧跟这些发展并掌握迁移学习的使用,从业者可以确保他们始终处于 NLP 研究和应用的最前沿。