卓越的流处理:Apache Flink 对 Data Lakehouse 架构的影响

在数据驱动决策的时代,Data Lakehouse 范式已成为一种很有前途的解决方案,它汇集了数据湖和数据仓库的优点。通过将数据湖的可扩展性和仓库的数据管理功能相结合,Data Lakehouses 提供了一个高度可扩展、敏捷且具有成本效益的数据基础设施。它们为分析和运营工作负载提供强大的支持,使组织能够从其数据中提取更多价值。

在我们之前的文章中,我们深入探讨了 Data Lakehouses 的概念。Data Lakehouses:可扩展、敏捷且具有成本效益的数据基础架构的未来通过强调 lakehouses 的关键业务优势奠定了基础。数据分析的新时代:探索 Data Lakehouse 架构的创新世界s 仔细研究了 lakehouse 的架构方面,而Delta、Hudi 和 Iceberg:Data Lakehouse Trifecta 则专注于三个主要的 lakehouse 解决方案:Delta Lake、胡迪和冰山。

当我们深入研究 Data Lakehouses 的世界时,一项因其潜力而脱颖而出的技术是 Apache Flink。Flink 以其卓越的流处理能力而闻名,它可以同时处理批处理和实时数据,这使其成为实施 Data Lakehouses 的一个引人注目的选择。此外,它还拥有高处理速度和容错能力,这些特性非常符合现代数据密集型应用程序的需求。

在本文中,我们旨在探索 Apache Flink 和 Data Lakehouses 的交叉点。我们将深入研究 Flink 的功能,将其与 Apache Spark 等其他技术进行比较,并说明如何在 Data Lakehouse 的上下文中利用它。通过提供实际示例,我们希望说明 Flink 在这个令人兴奋的领域中的潜力,并为那些考虑采用它的人提供见解。让我们踏上这段旅程,了解 Flink 如何成为 Data Lakehouse 领域的游戏规则改变者。

深入了解 Apache Flink

Apache Flink 是 Apache 软件基金会下的一个开源项目,是一个强大的流处理框架。凭借其熟练管理实时和批量数据处理的能力,Flink 在大数据领域产生了重大影响。其独特的功能,如容错和事件时间处理,使其能够提供快速准确的结果,使其成为数据处理领域的杰出竞争者。

虽然我们不会深入探讨 Flink 架构的复杂性,但重要的是要强调它的关键特性以及它们与其他大数据处理系统的区别。Flink 在称为“流-批统一”的独特原则下运行,该原则将批处理视为流处理的一个子集。这使得 Flink 可以同样熟练地管理有界(批)和无界(流)数据。

Flink 的架构设计包括几个重要的组件。JobManager相当于其他分布式系统中的主节点,负责协调分布式处理。TaskManagers,工作节点,负责执行任务,Source函数负责数据的接收,Sink函数负责结果的输出。这种结构让 Flink 可以有效地处理海量数据,按需横向扩展。

与其他大数据处理框架相比,Flink 的独特优势就显现出来了。其高速和低延迟的处理能力,即使在大规模操作中,也是值得关注的。Flink 还通过其异步检查点机制提供强一致性和容错性。此外,它对事件时间处理和窗口函数的支持使其特别适用于复杂的事件处理和时间序列分析。

在接下来的部分中,我们将深入探讨 Flink 在 Data Lakehouses 中的作用,并将其与另一个领先的大数据处理框架 Apache Spark 进行基准测试。

Apache Flink 在 Data Lakehouses 中的作用

随着组织越来越多地采用数据湖屋范例,对高效、灵活和强大的处理引擎的需求变得至关重要。Apache Flink 凭借其独特的架构和功能,非常适合担任这一角色。

Data Lakehouse 模型旨在将数据湖和数据仓库的最佳属性结合在一起。它需要处理大量结构化和非结构化数据,提供实时洞察力,并提供强大的数据治理。Flink 的架构和功能非常符合这些要求。

Flink 的“流批合一”原则使其能够高效地处理实时(无界)和历史(有界)数据。这在数据湖屋设置中尤为重要,在该设置中,实时数据摄取和分析可以与批处理作业共存。Flink 的高吞吐量和低延迟处理能力还可以实现及时的洞察力交付,这是数据驱动决策的重要方面。

此外,Flink 的容错机制提供了数据的一致性和可靠性,这对于确保 Lakehouse 环境中的数据完整性至关重要。其事件时间处理能力与窗口函数相结合,支持复杂的分析操作,包括复杂的事件处理和时间序列分析。这对于从湖屋中存储的数据中提取有价值的见解至关重要。

从本质上讲,Flink 能够处理海量数据,高效处理实时和批量数据,并提供可靠和一致的数据处理,非常符合数据湖屋的要求。在下一节中,我们将探讨 Flink 在数据湖屋的背景下如何与另一个著名的数据处理框架 Apache Spark 相抗衡。

Flink vs. Spark:Data Lakehouse 上下文中的比较分析

在大数据处理领域,Apache Spark 长期以来一直处于领先地位,以其多功能性和效率着称。然而,在实施数据湖屋时,Apache Flink 以其独特的属性提出了一个引人注目的案例。

Flink 和 Spark 之间的主要区别之一在于它们的数据处理方法。Spark 主要作为批处理系统运行,在其批处理引擎之上构建了流处理功能。相比之下,Flink 被设计为真正的流式引擎,批处理被视为流式处理的特例。这使得 Flink 更擅长处理实时数据,这是许多数据湖屋用例中的一个关键方面。

Flink 的事件时间处理是另一个使其优于 Spark 的特性。虽然 Spark 也支持事件时间处理,但 Flink 对延迟事件和水印的处理更加复杂,这对于确保准确的实时分析至关重要。

在容错方面,这两个框架都提供了健壮的机制。然而,与 Spark 的资源密集型方法相比,Flink 的轻量级异步检查点机制对性能的影响较小。

尽管存在这些差异,但请务必记住,Flink 和 Spark 之间的选择并不总是一场零和游戏。每种都有其优势,并且更适合某些场景。全面了解他们的能力可以帮助组织根据其特定的数据湖屋需求做出最佳选择。在下一节中,我们将展示一些使用 Flink 实现数据湖屋的实际示例。

使用 Apache Flink 实际实现 Data Lakehouses

实际示例极大地增强了对 Apache Flink 在数据湖屋设置中的功能的理解。在本节中,我们将讨论典型的实现并提供代码片段,以便更清楚地了解如何在 Data Lakehouse 环境中使用 Flink。

考虑一个 Data Lakehouse 架构,其中 Flink 作为实时数据处理层。它可以使用来自不同来源(例如 Kafka 或 IoT 设备)的数据,对其进行实时处理,并将其存储在数据湖中以供进一步使用。处理后的数据可以直接导入实时仪表板或用于触发警报。

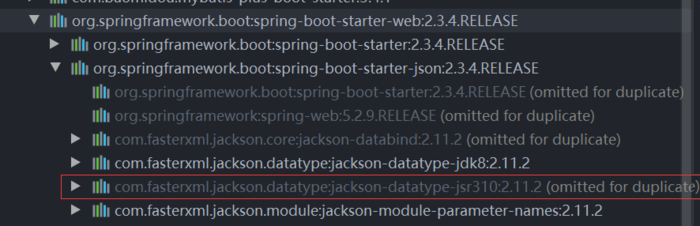

下面是一个简化的 Flink 代码片段,演示了从 Kafka 提取数据、处理数据并将结果写入 Sink:

// Create a StreamExecutionEnvironment

StreamExecutionEnvironment env = 域名xecutionEnvironment();

// Create a Kafka source

FlinkKafkaConsumer<String> kafkaSource = new FlinkKafkaConsumer<>(

"topic-name",

new SimpleStringSchema(),

kafkaProperties

);

// Add the source to the environment

DataStream<String> stream = 域名ource(kafkaSource);

// Process the data

DataStream<String> processedStream = 域名(new ProcessingFunction());

// Write the processed data to a Sink (e.g., HDFS)

StreamingFileSink<String> sink = StreamingFileSink

.forRowFormat(new Path("hdfs://output-path"), new SimpleStringEncoder<String>("UTF-8"))

.build();

域名ink(sink);

// Execute the Flink job

域名ute("Flink Data Lakehouse Job");

在上面的代码中,我们从 Kafka 主题中提取数据,使用假设的ProcessingFunction()对其进行处理,最后将处理后的数据写入 Hadoop 分布式文件系统 (HDFS) 接收器。此示例演示了 Flink 如何在数据湖屋中充当高效的数据处理层。

考虑零售业务中的一个用例,其中 Flink 处理实时客户活动数据并将洞察力提供给 lakehouse。然后可以利用这些见解来定制客户体验、调整库存或增强营销策略。

同样,金融机构可以利用 Flink 来处理实时交易数据。通过使用 Flink 执行复杂的事件处理,该机构可以在欺诈活动发生时检测到它们并立即采取行动。处理后的数据一旦存储在 lakehouse 中,便可用于生成详细报告和进一步分析。

此外,Flink 与流行的存储系统(如 HDFS、S3)和数据库(如 Cassandra 或 HBase)的兼容性确保了与现有数据基础架构的轻松集成。它能够与其他大数据工具(例如 Hadoop 和 Spark)进行互操作,使组织能够最大限度地利用现有技术投资。

在结论部分,我们将总结 Flink 在数据湖屋实施中的潜力,并讨论为什么它是一项值得考虑用于您的数据策略的技术。

案例研究:Apache Flink 在 Data Lakehouses 中的成功实施

为了进一步说明 Apache Flink 在数据湖屋架构中的实际用法,让我们深入研究一些组织已成功利用 Flink 功能的真实案例研究。

-

阿里巴巴集团:中国跨国企业集团阿里巴巴在其 Data Lakehouse 的各种实时计算场景中广泛使用 Flink。他们使用 Flink 进行实时搜索索引、在线机器学习和个性化推荐。通过采用 Flink,阿里巴巴每天能够实时处理数十亿个事件,显着提高了业务敏捷性和客户体验。

-

Uber:Uber 使用 Flink 处理实时和历史数据,以支持动态定价和供应定位等应用程序。Flink 统一批处理和流处理的能力及其强大的容错机制是 Uber 选择 Flink 的一些关键原因。这使 Uber 能够对市场变化做出更准确、实时的响应。

-

Netflix:Netflix 使用 Flink 作为其数据湖库的一部分,每天处理数十亿个事件,用于实时分析、异常检测和机器学习。Flink 处理大规模的能力及其复杂的窗口功能已被证明对 Netflix 的数据战略具有无可估量的价值。

这些示例展示了 Flink 在数据湖屋设置方面的潜力,以及不同企业如何利用其独特优势。随着组织继续为他们的数据湖屋寻找强大、可扩展和多功能的数据处理工具,Apache Flink 成为了一个强有力的竞争者。在最后一节中,我们将总结 Flink 在 Data Lakehouse 实施中的潜力,并讨论为什么它是一项值得考虑的技术。

结论:为什么 Apache Flink 是 Data Lakehouses 的一个引人注目的选择

在这个数据驱动决策的时代,强大、高效和多功能的数据基础设施的重要性怎么强调都不为过。数据湖屋概念结合了数据湖和数据仓库的优势,已成为管理复杂和多样化数据工作负载的有吸引力的解决方案。

Apache Flink 以其独特的架构和功能脱颖而出,成为实现数据湖屋的一种有前途的技术。它处理实时和批处理的能力、强大的容错能力和事件时间处理能力非常符合数据湖屋的要求。

此外,与 Apache Spark 等其他流行的数据处理框架相比,Flink 真正的流媒体特性以及对事件时间和水印的复杂处理提供了显着优势,特别是对于需要实时洞察和准确事件处理的用例。

我们讨论的实际示例和案例研究突出了 Flink 在适应各种数据工作负载方面的灵活性及其提供巨大商业价值的潜力。无论是零售业的实时客户活动分析、金融交易中的欺诈检测,还是为实时机器学习应用提供动力,Flink 都在各种场景中证明了自己的价值。

总之,随着组织不断发展他们的数据战略并寻求从他们的数据中提取更多价值,Apache Flink 提出了一个令人信服的考虑案例。它与 Data Lakehouse 模型保持一致,再加上其在处理复杂数据处理任务方面的独特优势,使其成为未来数据基础设施的一项激动人心的技术。